Закрыть от индексации в robots.txt страницу на сайте, текст, фильтр или поддомен

Что такое индексация?

Индексация - это процесс анализа страниц сайта поисковыми системами и внесение информации о них в Базу Данных (индекс) для последующего использования ее в ранжировании web-ресурсов и формирования поисковой выдачи.

Зачем нужны запреты от индексации?

Как правило, от поисковых систем закрывают информацию, которая не должна отображаться в поисковой выдаче - это разного рода техническая, служебная и конфиденциальная информация, страницы с непригодным для продвижения контентом. Чаще всего оптимизаторы запрещают для индекса дубли страниц, корзину, результаты поиска на сайте, личный кабинет пользователя.

Методы блокировок от индексации

На эту тему существует подробная инструкция от Google. Выделим два основных метода запрета индексации страницы:

-

С помощью robots.txt

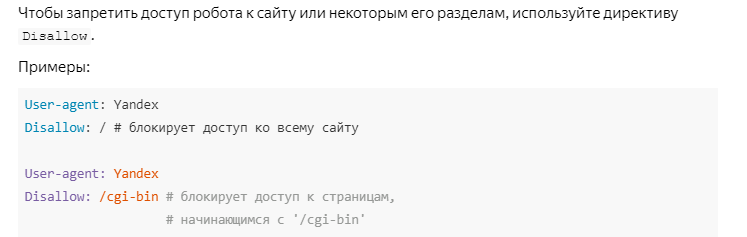

Robots.txt - это специальный текстовый файл, в котором содержатся рекомендации для поисковых систем о том, какие страницы можно индексировать, а какие не следует. Яндекс.Помощь дает подробное разъяснение по использованию файла

robots.txt, почитать которое можно здесь.Чтобы заблокировать страницу от индексации поисковых систем в

robots.txt, необходимо воспользоваться директивой Disallow. Пример от Яндекс:

-

При помощи тега <meta> robots с атрибутом noindex.

О правилах употребления noindex вы можете прочитать в нашей статье Страницы с тегом <noindex>. Чтобы заблокировать страницу с помощью этого атрибута, необходимо добавить в раздел страницы

<head>следующие строчки:<meta name="robots" content="noindex">- страница будет заблокирована для большинства поисковых роботовТакже можно закрыть страницу от какой-либо конкретной поисковой системы, например:

<meta name="googlebot" content="noindex">

Как обнаружить на сайте заблокированные от индексации страницы?

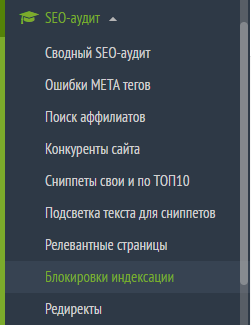

Иметь информацию о таких страницах необходимо хотя бы потому, что некоторые из них могут быть закрыты случайно, например, из-за ошибки при употреблении директив в robots.txt. К тому же, ссылаться на заблокированные URL не рекомендуется, потому что это нарушает передачу статического веса страниц. Посмотреть данные обо всех страницах вашего сайта с блокировкой от индексации вы можете с помощью сервиса Labrika. Находится отчет в подразделе "Блокировки индексации" раздела "SEO-аудит" в левом боковом меню:

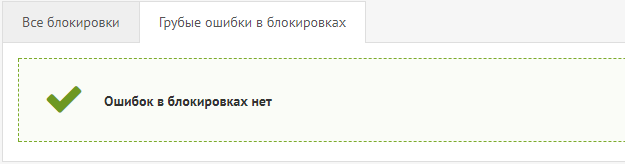

На странице отчета вы можете увидеть следующую информацию:

- Кнопка для обновления данных по сайту. При ее нажатии вы сможете получить свежий SEO-анализ по всем важным параметрам, в том числе - по блокировкам от индексации.

- На этой вкладке содержатся данные обо всех страницах, которые закрыты от индексации.

- Данные исключительно об ошибках в блокировках:

- URL страницы, которая закрыта от индексации.

- Информация о директиве в

robots.txt, если страница заблокирована этим способом. В данном случае, заблокированы все страницы, которые содержат в URL знак "?". - В случае, если блокировка прописана МЕТА-тегом robots, тут будут указываться данные о его содержимом.